Ještě donedávna táhl americkou ekonomiku po skončení pandemie mohutný boom v oblasti umělé inteligence. V posledních týdnech se ale kvůli vlně pochybností o smyslu velkých investic tento boom dočasně pozastavil. Hlavní oporou růstu byly masivní objednávky univerzálních AI GPU — tedy velmi výkonných, zároveň ale také velmi drahých a energeticky náročných akcelerátorů od Nvidie.

Jejich nejdůležitějšími konzumenty jsou takzvaní hyperscaleři, tedy obří americké technologické firmy jako Amazon, Google a Microsoft, které jimi plní stále monstróznější datacentra pro AI a cloud computing. Co když se ale skutečná AI revoluce odehrává jinde?

Kde přesně? Přece na periferii, tedy přesněji řečeno v zařízeních, s nimiž přicházíme do styku mnohem častěji než s blikajícími blackboxy uzavřenými v serverových raccích. Patří mezi ně například městský semafor, kamera, jež vás sleduje po cestě městě, nejrůznější kutilské projekty, IoT zařízení či jednoúčelový robotický pomocník v továrně nebo vaší domácnosti.

Řeč je o takzvané edge AI, místě, kde jsou drahé a náročné špičkové AI akcelerátory vyloženě nevhodné a kde již nějaký ten pátek vícero společností, mimo jiné Samsungem sponzorovaný jihokorejský DeepX, tvrdí, že jsou oproti Nvidii napřed.

I kdy to může znít na první pohled dost nabubřele, faktem zůstává, že edge AI se má k tomu, co si pod ní dnes představuje většina světa, zhruba stejně jako čipová architektura ARM k té x86 (dnes tedy spíš k té x64). Zatímco o x86 architektuře jako vítězi nikdo nepochyboval, ARM mezitím v tichosti ukradl celý nový mobilní segment a dnes si čím dál více ukrajuje také z koláče přenosných počítačů.

Najdeme zde i jiné paralely. Snaha prosadit se s x86 čipy na mobilním poli prostě nedávala příliš smysl, protože to bylo jako snažit se nacpat slona do krabičky od bot. Že se tam vejde kočka, neznamená, že tam dostanete každé zvíře. Něco podobného se možná právě teď odehrává na poli edge AI, kde současní leadeři trhu nejsou schopní škálovat od laboratorního stolu do masové výroby.

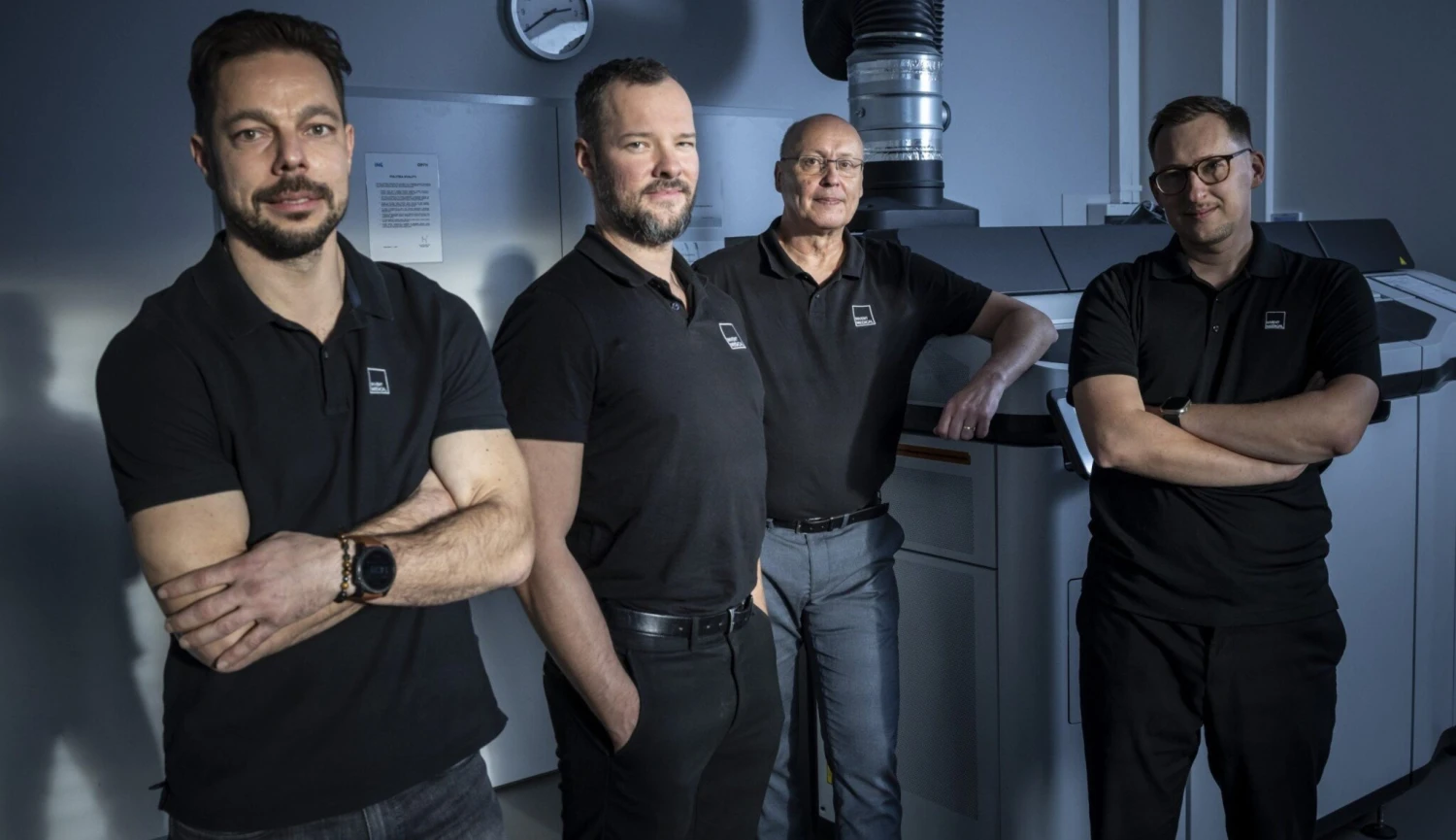

A právě to je příležitost pro společnosti, které na to jdou od zelené louky. Jednu takovou zde máme přímo v Evropě. Je jí v nizozemském Eindhovenu sídlící Axelera AI. Firma na sebe výrazněji upozornila 21. října, kdy představila nový AI čip, určený právě pro edge AI. Jmenuje se symbolicky Europa a jde o takzvané AIPU (AI processor unit) pro AI výpočty prováděné na takzvaných edge zařízeních.

Hodí se i pro zpracování hlavního zaklínadla dneška, tedy velkých jazykových modelů (LLM), a má spotřebu pouhých 45 wattů při výkonu 629 bilionů operací za sekundu. To jinými slovy znamená, že předčí některé produkty společnosti Nvidia při nižší spotřebě energie a, což je nejdůležitější, nižších nákladech v případě použití ve specifických scénářích, jako je třeba počítačové vidění nebo zpracování zmiňovaných LLM.

Pro srovnání, její předchůdce dosahoval výkonu maximálně 214 bilionů operací při spotřebě až osmi wattů.

„Strávili jsme roky snahou nacpat křemík určený pro hyperscale cloudová datová centra nebo mobilní telefony do náročných reálných edge AI aplikací. Výsledkem je hardware, který vypadá skvěle na papíře, ale pod tlakem moc nefunguje,“ shrnul na fóru AI Beyond The Edge tezi ze začátku tohoto článku minulý měsíc právě generální ředitel a spoluzakladatel společnosti Axelera AI Fabrizio Del Maffeo.

„Existuje obrovský rozpor mezi tím, o čem všichni mluví, a tím, co ve skutečnosti funguje v reálném světě,“ dodává.

Proč vlastně tradiční přístup, na němž jsou postaveny i technologie Nvidie, v případě edge AI computingu moc dobře nefunguje?

Potíž je v tom, že neuronové sítě fungují úplně jinak než tradiční počítače, postavené na myšlenkách geniálního matematika a počítačového vědce Johna von Neumanna. Umělá inteligence stráví sedmdesát až devadesát procent svého času násobením matic a vektorů, a to je docela hodně.

Tradiční přístup k počítačovým výpočtům, postavený na von Neumannově architektuře, ale má procesor a paměť oddělené, takže pokaždé, když je potřeba provést výpočet, musejí být data neustále přenášena přes čip tam a zpět. Tím se ale „zbytečně“ pálí mnohem více energie, než kolik jí nakonec padá na samotné „AI“ počítání.

V případě cloudových AI řešení pro hyperscalery to zatím příliš nevadilo, i když na enormní spotřebu AI datacenter si již začali v některých státech USA stěžovat občané, kteří se najednou potýkají s mnohem dražšími energiemi i s dříve ne tak frekventovanými výpadky sítě.

Jenže v případě edge AI, tedy nasazení na okraji sítě, například v IoT, kde hraje roli každý miliwatt a milisekunda, je podobná architektura neskutečně neefektivní.

Je tedy potřeba na to jít jinak. V teorii dokonce víme, jak na to. Z primárního výzkumu již nějaký čas zaznívají hlasy, že řešením by mohla být takzvaně neuromorfní výpočetní technika. A právě mezi její první reálné průkopníky Axelera AI patří.

Její architektura Digital In-Memory Computing funguje tak, že umisťuje paměťové a výpočetní prvky přímo vedle sebe, na stejném bloku. Tím dramaticky snižuje pohyb dat a dosahuje přitom velmi zajímavého výkonu.

Pokud ale čekáte, že se zde rodí nová evropská Nvidie, trochu vás zklamu, to ani není cílem. Nejde totiž o to, mít celkově nejlepší a nejrychlejší čip na trhu, ale mít technologii, která bude na rozdíl od něj skvěle optimalizovaná pro jeden úkol.

Tím je alfa a omega zátěže umělé inteligence na koncových zařízeních, tedy takzvané vysoce výkonné maticově-vektorové operace s nízkou latencí. Jinými slovy nepotřebujete být nejlepší ve všem, když dokážete být precizní a také konzistentně dobří v jednom směru.

The post AI revoluce na okraji. V Evropě roste nečekaný konkurent pro Nvidii appeared first on Forbes.